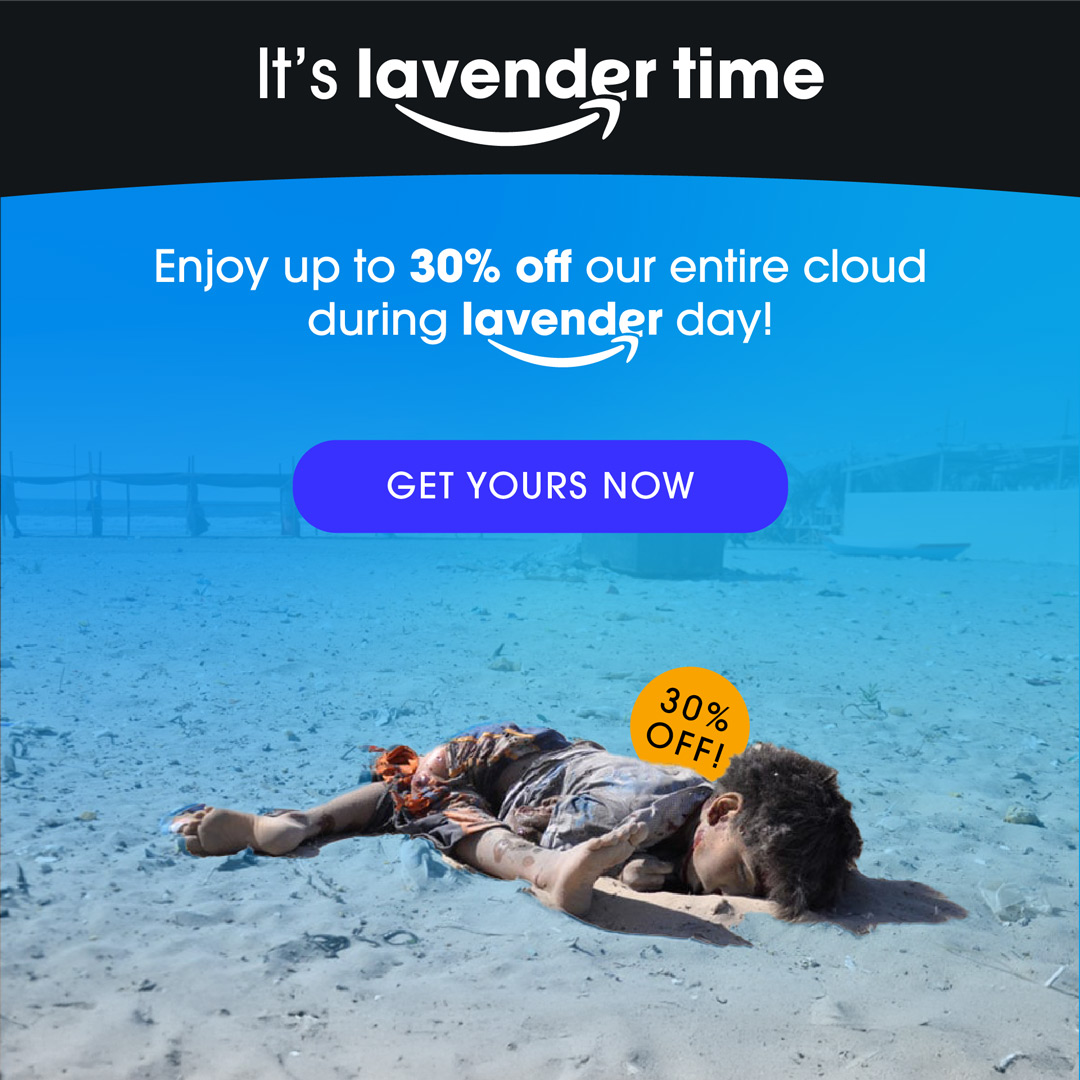

Lavender: l’algoritmo che decide chi vive e chi muore

Grazie ad Amazon e Google l'esercito israeliano ha potuto sviluppare un sistema di intelligenza artificiale che ha trasformato Gaza in un laboratorio di guerra automatizzata, dove un algoritmo decide sulla vita delle persone.

Si chiama Lavender e seleziona in modo automatico i palestinesi da colpire: analizza dati su ognuno dei 2 milioni di abitati di Gaza e genera liste di sospetti da bombardare, spesso senza nemmeno una verifica umana. È l’algoritmo dietro decine di migliaia di morti civili e la devastazione di un'intera terra. E intanto Amazon guadagna milioni di dollari per fornire ad Israele lo spazio in cui poter schedare ogni singolo abitante di Gaza.

Un clic per uccidere

37.000 obiettivi colpiti grazie a un punteggio calcolato da una macchina.

Lavender assegna un punteggio di “sospetto militante” a quasi ogni abitante di Gaza. Se il punteggio è alto, la persona finisce in una lista da colpire. Soldati israeliani raccontano che in media bastano 20 secondi per approvare un bombardamento: assicurarsi che la voce al di là del telefono sia maschile e che preferibilmente si trovi in casa. Raccontano che sono tollerate fino a 10 vittime collaterali per ogni obbiettivo di basso profilo e fino a 100 per ogni militante adulto colpito.

Famiglie distrutte, errori ignorati

L’IA ha ucciso donne e bambini sulla base di dati ricavati dai loro telefoni cellulari.

L’algoritmo Lavender sbaglia almeno nel 10% dei casi, ma l’esercito ha accettato questo rischio. Ha colpito case intere di notte, tende, ambulanze, sapendo che dentro c’erano intere famiglie.

Complicità nella nuvola

Amazon, Google e Microsoft hanno fornito le infrastrutture usate per uccidere.

I server su cui gira Lavender appartengono a giganti tech occidentali. Le infrastrutture cloud offerte da Amazon Web Services e Google Cloud hanno permesso all’esercito israeliano di archiviare, elaborare e colpire con rapidità algoritmica.

Crimini nascosti sotto il nome dell’innovazione

Le Nazioni Unite parlano di “possibili crimini di guerra” e “genocidio”.

Secondo esperti ONU e ONG, l’uso di Lavender ha violato il diritto internazionale umanitario. Attacchi indiscriminati, proporzionalità ignorata, vite umane ridotte a dati. Questa è la nuova frontiera della guerra – e dei crimini senza volto.

Non restare a guardare

Agisci ora per fermare la complicità tecnologica nei crimini di guerra. Non cascarci! Amazon viene a Lucca a ripulirsi le mani sporche del sangue di migliaia di innocenti. Per aziende come Amazon siamo solo dati da vendere, perché i profitti sono molto più importanti della vita delle persone. La guerra non può essere lasciata in mano a un algoritmo. La vita umana non è un dato da cancellare. Aderisci al boicottaggio internazionale delle big tech agendo subito. Fai la tua parte, Cancella il tuo abbonamento a Prime, non comprare niente su Amazon.